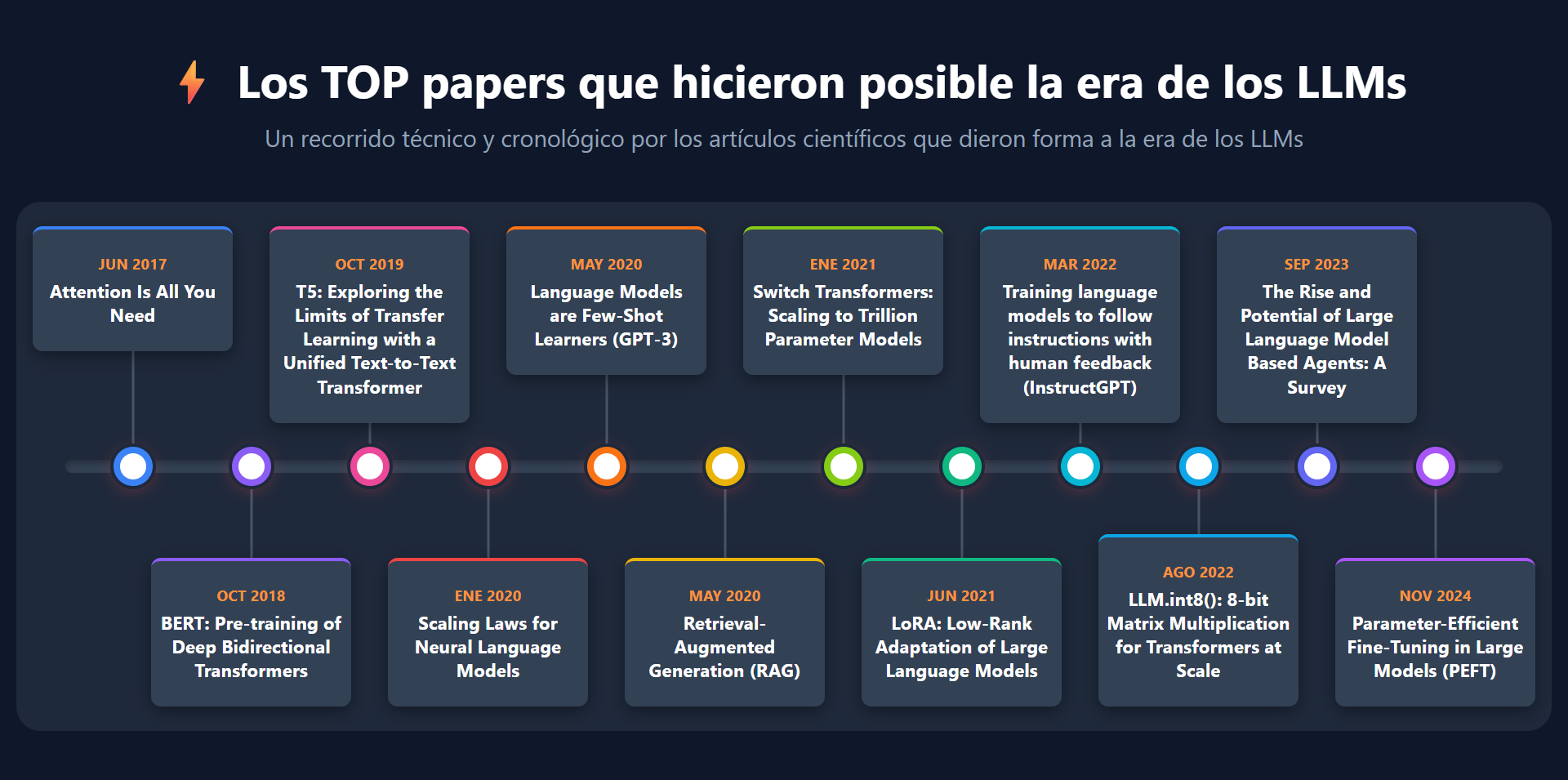

Los TOP papers que hicieron posible la era de los LLMs

A lo largo de la historia, los grandes avances tecnológicos suelen seguir un patrón claro: primero la invención, fruto de la investigación; después la industrialización, que hace la idea escalable y útil; luego la optimización, que la perfecciona y abarata. Este ciclo puede verse en distintos momentos de la historia como en la penicilina, la máquina de vapor, o el microprocesador. Avances científicos que, tras su aparición, evolucionaron desde el hallazgo científico hasta convertirse en soluciones ampliamente utilizadas.

La evolución reciente de los LLMs (Large Language Models) encaja claramente en este patrón. Primero vino la invención, con investigaciones que sentaron las bases —como la arquitectura Transformer en 2017—. Luego llegó la industrialización, con modelos cada vez más grandes y potentes y después, la optimización, que redujo costes y amplió capacidades. Ahora vivimos una etapa de democratización, en la que estas tecnologías se abren a empresas y usuarios de todo el mundo (desarrollado).

En este artículo presentaré (según mi opinión y conocimiento) los artículos científicos clave que han impulsado cada etapa de desarrollo, mostrando cómo la investigación ha sido el motor que ha llevado a los LLMs a su expansión actual.

🧠 1. Invención (2017-2019) – Transformers, la base de la revolución

En 1928, cuando Alexander Fleming descubrió la penicilina, no resolvió por sí solo todas las enfermedades, pero sentó las bases científicas de la medicina antibiótica moderna, que con el tiempo salvaría cientos de millones de vidas.

Algo similar —aunque en un campo muy distinto— ocurrió en 2017 con la publicación de Attention Is All You Need, el artículo de Google en el que se presentaban los Transformers, una nueva arquitectura de red neuronal que estableció la base científica sobre la que se ha construido toda la revolución de los LLMs.

📄 Attention Is All You Need – Junio 2017

📎 https://arxiv.org/abs/1706.03762

En este paper se presentó la arquitectura Transformer, un enfoque mucho más eficiente computacionalmente y más preciso que los modelos secuenciales (RNN y LSTM) utilizados hasta la fecha. Su gran innovación fue el uso de mecanismos de atención, que permite procesar el texto de forma paralela y captar con mayor profundidad las relaciones semánticas entre palabras y frases. Esta capacidad no solo mejoró el rendimiento en tareas de comprensión y generación de lenguaje, sino que también facilitó la escalabilidad, permitiendo entrenar modelos más grandes y con mayor eficiencia.

📄 BERT: Pre-training of Deep Bidirectional Transformers – Octubre 2018

📎 https://arxiv.org/abs/1810.04805

BERT (Bidirectional Encoder Representations from Transformers) es un modelo de lenguaje desarrollado por Google. Antes de su aparición, la mayoría de los modelos leían los textos en una sola dirección —de izquierda a derecha o de derecha a izquierda—, lo que limitaba su capacidad para comprender el contexto completo de una frase.

BERT cambió este enfoque al introducir un modelo bidireccional, capaz de «leer» simultáneamente en ambas direcciones, entendiendo así mejor el significado de cada palabra según su contexto.

El paper también propuso un método para preentrenar el modelo con grandes volúmenes de texto (como si a alguien le enseñasen a leer) y luego ajustarlo fácilmente a distintas tareas (como si alguien que sabe leer, utiliza la lectura para aprender a resolver «algo») clasificación de texto, análisis de sentimientos o respuestas a preguntas. Gracias a esta estrategia, un mismo modelo podía reutilizarse en múltiples aplicaciones.

📄 T5: Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer – Octubre 2019

📎 https://arxiv.org/abs/1910.10683

T5 (Text-to-Text Transfer Transformer) es un modelo desarrollado por Google que llevo la idea un paso más allá. Mientras que muchos modelos anteriores requerían arquitecturas distintas para cada tarea —por ejemplo, una para clasificar textos, otra para responder preguntas, otra para traducir—, T5 propuso unificarlo todo en un único marco «texto-a-texto».

La idea era sencilla: cualquier problema de lenguaje se podía proponer como la generación de un texto a partir de otro texto. Por ejemplo, si la tarea era traducir, se le daba un texto y se pedía su traducción; si era responder preguntas, se le daba la pregunta y debía generar la respuesta, etc.

Este enfoque simplificó muchísimo la arquitectura e hizo mucho más fácil reutilizar un mismo modelo para múltiples tareas, anticipando así la lógica de los LLMs actuales: un único modelo generalista que puede adaptarse a distintos usos con ajustes mínimos.

🚀 2. Industrialización (2020-2021) – La gran expansión de la IA

Cuando James Watt perfeccionó la máquina de vapor en 1769, no inventó la energía térmica ni el vapor, pero logró escalar esa tecnología y convertirla en el motor de toda una revolución industrial.

Algo similar ocurrió con los LLMs a partir de 2020. Los Transformers ya existían, pero fue en esta etapa cuando la investigación se centró en cómo hacerlos crecer, entrenarlos con enormes volúmenes de datos y grandes recursos computacionales, demostrando que, al aumentar su tamaño, también aumentaba su capacidad. Esta es la etapa en la que los LLMs dejaron de ser prototipos experimentales para convertirse en infraestructuras tecnológicas globales.

A continuación, veremos algunos de los papers clave que marcaron este salto y definieron esta nueva etapa:

📄 Scaling Laws for Neural Language Models – Enero 2020

📎 https://arxiv.org/abs/2001.08361

Este paper, desarrollado por OpenAI, formuló las «leyes de escalamiento» (Scaling Laws), que demostraban que el rendimiento de los modelos de lenguaje aumenta a medida que crecen su tamaño, la cantidad de datos de entrenamiento y la capacidad de cómputo. Este hallazgo proporcionó una base empírica sólida que no solo justificó la apuesta por modelos cada vez más grandes, sino que también marcó una hoja de ruta para toda la industria. Para OpenAI, representó un punto de inflexión estratégico, ya que permitió atraer inversión a gran escala y sentar las bases para el desarrollo de GPT-3 y, más tarde, de ChatGPT, impulsando una nueva etapa en la historia de la inteligencia artificial generativa.

📄 Language Models are Few-Shot Learners (GPT-3) – Mayo 2020

📎 https://arxiv.org/abs/2005.14165

El paper de GPT-3, desarrollado por OpenAI, mostró por primera vez que un modelo de lenguaje —con 175 mil millones de parámetros— podía realizar múltiples tareas sin necesidad de ser reentrenado, simplemente a partir de unos pocos ejemplos incluidos en el prompt. Este fenómeno, conocido como «few-shot learning» (aprendizaje con pocos ejemplos) demostró que, al aumentar el tamaño de los modelos, estos también ganaban capacidad para adaptarse a distintas tareas, mostrando habilidades para las que no habían sido entrenados directamente.

Este descubrimiento fue un punto de inflexión en la evolución de los LLMs, sentando las bases conceptuales de lo que más tarde sería ChatGPT.

📄 Retrieval-Augmented Generation (RAG) – Mayo 2020

📎 https://arxiv.org/abs/2005.11401

El paper de RAG, desarrollado por Meta AI, introdujo una idea clave: combinar modelos de lenguaje con fuentes externas de información. Hasta ese momento, los LLMs solo podían generar respuestas basadas en lo aprendido durante su entrenamiento, lo que «congelaba» su conocimiento a los datos vistos en esa etapa.

RAG propuso un enfoque diferente: permitir que el modelo «consulte» bases de conocimiento externas en tiempo real, recuperando documentos relevantes para usarlos como entrada (prompting) y generar una respuesta informada.

Imagina que un LLM ha sido entrenado con documentos generados hasta el 1 de enero de 2025, que incluyen el reglamento oficial de fútbol. Si el 15 de enero se publica una nueva versión del reglamento con normas nuevas o modificadas, un sistema basado en RAG podría incorporar ese nuevo texto en una base externa y responder preguntas según las reglas actualizadas, sin necesidad de reentrenar el modelo (lo cual es extremadamente costoso).

De esta forma, el modelo no solo «recuerda», sino que también «busca» (mediante el uso de embeddings), mejorando la precisión y manteniendo la información actualizada. Este enfoque marcó un paso fundamental hacia los sistemas modernos que integran LLMs con buscadores, bases de datos o APIs externas, abriendo el camino a asistentes capaces de combinar razonamiento lingüístico con acceso dinámico a información.

📄 Switch Transformers: Scaling to Trillion Parameter Models – Enero 2021

📎 https://arxiv.org/abs/2101.03961

El paper de Switch Transformers (Transformers conmutables), desarrollado por Google, abordó uno de los grandes desafíos en los LLMs: el grandísimo coste computacional del entrenamiento. A medida que los modelos crecían en tamaño, entrenarlos se volvía cada vez más caro y lento. Este trabajo propuso una solución ingeniosa: activar solo una parte específica del modelo, en lugar de utilizarlo por completo.

La idea se basa en una arquitectura de tipo «mixture of experts» (mezcla de expertos), donde el modelo contiene múltiples «bloques» o subredes neuronales especializadas, activándose solo las más relevantes para cada entrada. Así, aunque el modelo completo pueda tener billones de parámetros, solo una fracción se usa en cada proceso, reduciendo drásticamente el consumo de cómputo sin sacrificar precisión ni calidad.

Imagina una gran empresa con miles de trabajadores, en lugar de reunirlos a todos para cada decisión, solo se consulta a los que mejor conocen el tema. El modelo funciona igual, seleccionando dinámicamente los «expertos» (subredes neuronales) más adecuadas según el texto de entrada.

Este enfoque permitió entrenar y ejecutar modelos de manera mucho más eficiente y sostenible, marcando un antes y un después en el diseño de LLMs. Además, introdujo un principio que sigue siendo clave hoy: no se trata solo de crear modelos más grandes, sino de hacerlos más inteligentes en cómo utilizan sus recursos.

📄 LoRA: Low-Rank Adaptation of Large Language Models – Junio 2021

📎 https://arxiv.org/abs/2106.09685

LoRA, desarrollado por Microsoft, propuso una forma revolucionaria de adaptar los LLMs ya entrenados sin tener que reentrenarlos por completo. Hasta entonces, reentrenar un LLM implicaba modificar todos sus parámetros, lo cual era extremadamente costoso.

LoRA ofreció una solución elegante: mantener congelado el modelo original y añadir pequeñas capas entrenables dentro de su arquitectura. Estas capas aprenden de los nuevos datos de entrenamiento, y sus resultados se combinan con los del modelo original durante la inferencia, permitiendo personalizar el comportamiento sin alterar el conocimiento general.

En otras palabras, LoRA demostró que no era necesario reentrenar todo el modelo para enseñarle algo nuevo, bastaba con incorporar pequeñas adaptaciones ligeras y eficientes. Este enfoque redujo drásticamente los costes y simplificó la adaptación de los LLMs, haciendo posible que organizaciones más pequeñas pudieran personalizar los LLMs sin que les supusiese grandes costes. En la práctica, LoRA democratizó el fine-tuning y abrió la puerta a una nueva generación de modelos más especializados y accesibles.

Con los avances de Scaling Laws, GPT-3, RAG, Switch Transformer y LoRA, los LLMs alcanzaron la madurez necesaria para dar el salto a productos reales. Esto lo vemos en herramientas como ChatGPT, Claude, DeepSeek, GitHub Copilot, etc. que ya se han integrado en nuestro día a día.

🛠 3. Optimización (2022 – 2024) — Se mejora y abarata

En 1947, Bardeen, Brattain y Shockley inventaron el transistor, siendo la base tecnológica sobre la que se construyeron los microprocesadores modernos. Esa innovación sentó las bases para que en 1971 se crease el Intel 4004, el primer microprocesador con 2300 transistores integrados. Desde entonces, la historia de la computación ha sido una carrera por optimizar y reducir costes, haciendo los chips cada vez más potentes, compactos y accesibles, teniendo hoy en día procesadores como los Intel Core i7 que integran miles de millones de transistores.

Algo similar ocurrió con las herramientas basadas en LLMs ya construidas. El reto pasó a ser mejorarlas, hacerlas más eficientes y útiles para las personas. Entre 2022 y 2024, las investigaciones se centraron en tres frentes: mejorar la eficiencia de los modelos mediante técnicas de optimización, dotarlos de mayor funcionalidad con capacidades de razonamiento y uso de herramientas externas y conseguir una mejor interacción con las personas.

El resultado fue un salto cualitativo, los LLMs dejaron de limitarse a generar texto para convertirse en sistemas útiles, precisos y colaborativos. Veamos a continuación algunos de los papers clave:

📄 LLM.int8(): 8-bit Matrix Multiplication for Transformers at Scale – Agosto 2022

📎 https://arxiv.org/abs/2208.07339

Este paper introdujo una técnica clave dentro del ámbito de la cuantificación (Quantization) para reducir el tamaño y el coste computacional de los LLMs. La cuantificación consiste en reducir la precisión numérica con la que los modelos almacenan y procesan sus parámetros —es decir, usar números con menos decimales—. De esta forma, los valores ocupan menos memoria y las operaciones se ejecutan mucho más rápido. El desafío está en que, al reducir los decimales, los modelos tienden a perder precisión y calidad en sus resultados.

LLM.int8() demostró que era posible aplicar cuantificación de 8 bits sin degradar significativamente el rendimiento, incluso en modelos de miles de millones de parámetros. Su innovación fue una estrategia de cuantificación híbrida, que usaba 8 bits para la mayoría de los cálculos y 16 bits solo en aquellos casos con activaciones atípicas (outliers), donde los valores numéricos son especialmente grandes.

Este enfoque redujo aproximadamente a la mitad el uso de memoria y permitió ejecutar grandes modelos en una sola GPU, haciendo posible el trabajo con LLMs de alta escala de forma mucho más accesible y económica.

En conjunto, LLM.int8() se convirtió en un punto de referencia en la optimización de modelos, demostrando que el progreso no siempre depende de construir modelos más grandes, sino de hacerlos más eficientes e inteligentes en el uso de sus recursos.

📄 Training language models to follow instructions with human feedback (InstructGPT) – Marzo 2022

📎 https://arxiv.org/abs/2203.02155

En este paper, OpenAI transformó la manera en que los modelos de lenguaje se relacionan con las personas. El trabajo se centró en hacer que los LLMs ofrecieran respuestas más parecidas a las que daría un ser humano, introduciendo el método Reinforcement Learning from Human Feedback (RLHF): un proceso en el que evaluadores humanos califican y comparan las respuestas del modelo, proporcionando ejemplos de cómo debería comportarse ante diferentes instrucciones.

A partir de ese feedback, el modelo aprende a priorizar respuestas más claras, seguras y útiles, ajustando su comportamiento hacia lo que las personas realmente esperan. El resultado fue un modelo que no solo predice palabras, sino que entiende y sigue instrucciones (Instruct) de forma coherente.

InstructGPT demostró que la optimización de los LLMs no depende únicamente de la eficiencia técnica, sino también de su capacidad para comunicarse e interactuar de manera más natural con las personas, haciendo que la inteligencia artificial resulte más comprensible, cooperativa y humana.

📄 Parameter-Efficient Fine-Tuning in Large Models (PEFT) – Noviembre 2024

📎 https://arxiv.org/html/2410.19878v2

Este survey (revisión de diferentes artículos de investigación) recopila y analiza las principales técnicas de «Ajuste fino y eficiente de parámetros» (Parameter-Efficient Fine-Tuning, PEFT). Estas técnicas surgieron para abordar un problema clave: cómo adaptar los LLMs sin necesidad de reentrenar todos sus parámetros, algo extremadamente costoso en tiempo y recursos.

El estudio reúne métodos como LoRA, Prompt Tuning, Prefix-Tuning o P-Tuning, todos ellos con un objetivo común: personalizar un modelo grande modificando solo una pequeña fracción de sus parámetros. Gracias a estos enfoques, los LLMs pueden resolver nuevas tareas —como clasificación de textos, análisis de sentimientos o generación de código— de forma rápida y eficiente, sin perder el conocimiento general aprendido previamente.

En conjunto, este trabajo consolidó un campo de investigación esencial para la optimización práctica de los LLMs, haciendo posible su adaptación flexible, modular y asequible, permitiendo que más organizaciones pudieran aprovechar su potencial sin depender de grandes infraestructuras.

📄 The Rise and Potential of Large Language Model Based Agents: A Survey – Septiembre 2023

📎 https://arxiv.org/abs/2309.07864

Este survey analiza el surgimiento de los agentes de lenguaje (LLM Agents), una nueva generación de sistemas basados en LLMs que no solo generan texto, sino que también razonan, planifican y actúan de forma autónoma. Los agentes están compuestos por varios elementos que les permiten interactuar de manera más inteligente con su entorno:

- Modelo central (LLM): el núcleo que interpreta las instrucciones y genera razonamientos o planes.

- Memoria: almacena información de interacciones pasadas para mantener contexto y coherencia.

- Herramientas externas: permiten al agente acceder a buscadores, bases de datos o APIs para obtener información o ejecutar acciones.

- Planificador: descompone un objetivo complejo en pasos lógicos y decide cuando y qué acciones realizar.

Gracias a esta estructura modular, los agentes LLM pueden resolver tareas complejas, aprender del contexto y ejecutar acciones en tiempo real. El estudio consolidó el concepto de «agente» dentro del ecosistema de los LLMs y marcó un paso clave hacia sistemas más autónomos y prácticos.

Aunque hoy el término «agente inteligente» suene moderno, su origen se remonta a los años 80 dentro del campo de la inteligencia artificial. Como anécdota de quien os escribe estas líneas, cursé en la universidad la asignatura de Agentes Inteligentes en el curso 2009/2010. Recuerdo perfectamente que el 27 de enero de 2010, el profesor canceló la clase de esa asignatura porque coincidía con un evento que a la postre resultaría «histórico»: la presentación del iPad por parte de Steve Jobs.

Con estos avances mostrados, los LLMs alcanzaron un nuevo nivel de madurez. Ya no se trataba solo de hacerlos más grandes, sino de hacerlos más útiles, rápidos y eficientes. Esta fase consolidó la base técnica sobre la que hoy se construyen los modelos más avanzados, abriendo el camino hacia su expansión y adopción global.

🤝 4. Democratización (2023 – 2025) — Los LLMs se abren al mundo

En febrero de 2023, Meta AI liberó LLaMA, su modelo LLM. Con esta decisión, los modelos de lenguaje dejaron de ser una tecnología reservada a las grandes empresas y pasaron a convertirse en un recurso abierto y colaborativo.

Otras compañías siguieron su ejemplo: Mistral AI con Mistral 7B (septiembre de 2023), Google con Gemma (febrero de 2024) o DeepSeek AI con DeepSeek-V2 (mayo de 2024), entre otras. Algunas publicaron solo el modelo, y otras también su código fuente, bajo licencias más o menos restrictivas, pero todas contribuyeron a expandir el acceso y la experimentación.

La apertura de estos modelos desencadenó una auténtica revolución, permitiendo que desarrolladores y organizaciones los adaptaran a ámbitos tan diversos como la educación, la medicina o el derecho. Plataformas como Hugging Face también jugaron un papel clave al facilitar el intercambio de modelos entrenados y especializados, consolidándose como el gran punto de encuentro del ecosistema open source. De este modo, surgió un entorno abierto y colaborativo, donde la innovación ya no depende solo de las grandes corporaciones, sino también de una comunidad global que experimenta, mejora y comparte conocimiento.

A continuación, mostramos los «technical reports» e información de los modelos libres de Meta, Mistral y DeepSeek:

📄 LLaMA – Meta AI (2023-2025)

- LLaMA (febrero 2023) 📎 https://arxiv.org/abs/2302.13971: Primer modelo LLaMA, diseñado con datos públicos y gran eficiencia. Su apertura permitió que la comunidad científica accediera por primera vez a un modelo competitivo desarrollado por una gran empresa.

- LLaMA 2 (julio 2023) 📎 https://arxiv.org/abs/2307.09288: Segunda generación de LLaMA, que incluyó versiones conversacionales (chat models) y licencias que permitían incluso uso comercial, ampliando enormemente su adopción.

- LLaMA 3 (julio 2024) 📎 https://arxiv.org/abs/2407.21783: Tercera generación con mejoras en rendimiento, alineamiento y escalabilidad. Consolidó a LLaMA como uno de los pilares del ecosistema abierto de LLMs.

- LLaMA 4 (abril 2025) 📎 https://ai.meta.com/blog/llama-4-multimodal-intelligence/: Cuarta generación que introduce arquitectura Mixture-of-Experts (MoE), capacidad multimodal (texto, imagen, vídeo) y contextos ultra-largos.

📄 Mistral AI (2023–2025)

Empresa europea, se convirtió en una de las principales impulsoras de modelos abiertos, apostando por la eficiencia y la accesibilidad.

- Mistral 7B (septiembre 2023) 📎 https://arxiv.org/abs/2310.06825: Modelo de 7 000 millones de parámetros bajo licencia Apache 2.0. Su arquitectura optimizada (grouped-query attention y sliding-window attention) lo hizo destacar sobre modelos más grandes.

- Mixtral 8×7B (diciembre 2023): Modelo tipo Mixture of Experts (MoE) que combina ocho expertos de 7B cada uno, activando solo los necesarios para cada tarea, lo que mejora la eficiencia sin perder calidad.

- Voxtral Technical Report (julio 2025): Amplía el enfoque hacia la comprensión del habla y los modelos multimodales.

📄 DeepSeek AI – (2024-2025)

Desde China, DeepSeek AI emergió como uno de los proyectos open source más sólidos y ambiciosos, destacando por su eficiencia y especialización.

- DeepSeek-Coder (enero 2024) 📎 https://arxiv.org/abs/2401.14196: Modelo especializado en programación y generación de código, entrenado con un dataset masivo de repositorios públicos.

- DeepSeek-V2 (mayo 2024) 📎 https://arxiv.org/abs/2405.04434: Introduce una arquitectura Mixture of Experts con «Multi-Head Latent Attention» y DeepSeekMoE, optimizando rendimiento y coste computacional.

- DeepSeek-R1 (enero 2025) 📎 https://arxiv.org/abs/2501.12948: Explora el razonamiento lógico con una técnica llamada Reinforcement Learning with Reasoning Feedbacks (RLRF), que incentiva pasos de pensamiento más estructurados.

En solo unos años, los LLMs han pasado de ser un experimento académico para convertirse en una de las mayores transformaciones tecnológicas de nuestro tiempo. Desde su invención con el Transformer, hasta su apertura al público con proyectos como LLaMA, Mistral o DeepSeek, la inteligencia artificial ha evolucionado desde el laboratorio hasta el uso cotidiano, cambiando la manera en que aprendemos, trabajamos y creamos.

Hoy, los LLMs representan mucho más que una herramienta: son un nuevo lenguaje entre humanos y máquinas, un espacio abierto donde la innovación surge de la colaboración global.

Listado de los papers mencionados en el artículo ordenados cronológicamente:

- ➡️ Attention Is All You Need – Jun 2017 📎 https://arxiv.org/abs/1706.03762

- ➡️ BERT: Pre-training of Deep Bidirectional Transformers – Oct 2018 📎 https://arxiv.org/abs/1810.04805

- ➡️ T5: Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer – Oct 2019 📎 https://arxiv.org/abs/1910.10683

- ➡️ Scaling Laws for Neural Language Models – Ene 2020 📎 https://arxiv.org/abs/2001.08361

- ➡️ Language Models are Few-Shot Learners (GPT-3) – May 2020 📎 https://arxiv.org/abs/2005.14165

- ➡️ Retrieval-Augmented Generation (RAG) – May 2020 📎 https://arxiv.org/abs/2005.11401

- ➡️ Switch Transformers: Scaling to Trillion Parameter Models – Ene 2021 📎 https://arxiv.org/abs/2101.03961

- ➡️ LoRA: Low-Rank Adaptation of Large Language Models – Jun 2021 📎 https://arxiv.org/abs/2106.09685

- ➡️ Training language models to follow instructions with human feedback (InstructGPT) – Mar 2022 📎 https://arxiv.org/abs/2203.02155

- ➡️ LLM.int8(): 8-bit Matrix Multiplication for Transformers at Scale – Ago 2022 📎 https://arxiv.org/abs/2208.07339

- ➡️ The Rise and Potential of Large Language Model Based Agents: A Survey – Sep 2023 📎 https://arxiv.org/abs/2309.07864

- ➡️ Parameter-Efficient Fine-Tuning in Large Models (PEFT) – Nov 2024 📎 https://arxiv.org/html/2410.19878v2